Blogbeitrag

Entscheidende KI in Führung

Timm Richter, 5. Januar 2026

KI – genauer und vor allem generative KI in der Form von sprachmodellbasierten KI-Assistenten / KI-Agenten – wird als neue Technologie von Organisationen, Führungskräften und Mitarbeitenden ausprobiert und dahingehend beobachtet, welchen Unterschied sie in Organisationen bereits macht oder machen kann. Während die industrielle Revolution Handarbeit massiv verändert hat, stellt sich nun die Frage, wie sich Wissensarbeit (in Organisationen) verändern wird, welche Aufgaben und Rollen wegfallen bzw. neu und anders definiert werden. Die Überlegungen machen selbst vor Führungskräften nicht halt, es gibt intensive Diskussionen, inwieweit generative KI Führungsaufgaben übernehmen kann.

Entscheidungen passieren und danach werden Personen verantwortlich gemacht

Aus einer systemtheoretischen Perspektive beginnt das Nachdenken über diese Frage mit der Trennung von Führung und Führungskräften und der Erinnerung, wie Organisationen systemtheoretisch konzeptionalisiert werden. Organisationen werden verstanden als ein sich selbst erzeugtes und erhaltendes Netzwerk von Entscheidungen. Dementsprechend interessieren uns die Auswirkungen von generativer KI auf ebendiese Entscheidungen.

Organisationale Entscheidungen sind eine besondere Form der Kommunikation, nämlich die Kommunikation einer Auswahl aus (zwei) Alternativen, die dann – beobachtbar im Nachgang – von der Organisation bei Folgeentscheidungen als entschieden berücksichtigt wird. So gesehen entscheidet eine Organisation sich immer selbst, oder etwas weniger anthropomorph formuliert: In einem Entscheidungsprozess kommt es (emergent) zu einer Entscheidung, die berücksichtigt wird, ohne dass ein kausal eindeutig determinierender Verursacher benannt werden könnte. Entscheidungen werden zwar Entscheider:innen (z.B.: einer Führungskraft, einem (seine Kompetenzen überschreitenden) Mitarbeiter, den Personen in einem Entscheidungsgremium, etc.) zugeschrieben, aber diese Zuschreibung blendet entscheidende Zusammenhänge aus: Es macht einen Unterschied für die Entscheidung, wer was wann mit welcher zugeschriebenen Kompetenz im Entscheidungsprozess als Idee oder Argument eingebracht hat, welchen zugeschriebenen „Track-Record" vermeintliche Entscheider:innen haben, was diese über die Erfolgsaussichten von möglichen Entscheidungen denken und wie letztendlich Entscheidungen im Nachgang interpretiert und „gelebt" werden. So gibt es also vor und nach Entscheidungen vielfältige Kommunikationen von verschiedensten Kommunikationsteilnehmern und vielfältigste Kontextbedingungen (z.B. auch: zeitliche Restriktionen), die alle die Entscheidung beeinflussen, ohne dass zwingend das einzig auslösende Moment des Entscheidens zu identifizieren wäre. Oder anders formuliert: Während eine Entscheidung als selbst erzeugter Prozess ohne berechenbaren Verursacher verstanden werden kann – (personale) Verantwortung bleibt unbestimmt -, wird die Verantwortlichkeit in den meisten Fällen einer oder mehreren entscheidenden Personen zugeschrieben (also im Übrigen auch entschieden und spätestens hier, wenn über die Verteilung von Schuld gestritten wird, merkt man, dass Entscheidungen unbeherrschbare Prozesse sind).

Mit so einem Blick auf Organisationen ist offensichtlich, dass auch generative KI in Form von Sprachmodellen basierten KI-Assistenten entscheidende Beiträge zu Entscheidungsprozessen liefern kann und bereits liefert.

Die Möglichkeit: KI-Assistenten als funktionales Äquivalent zu Personal

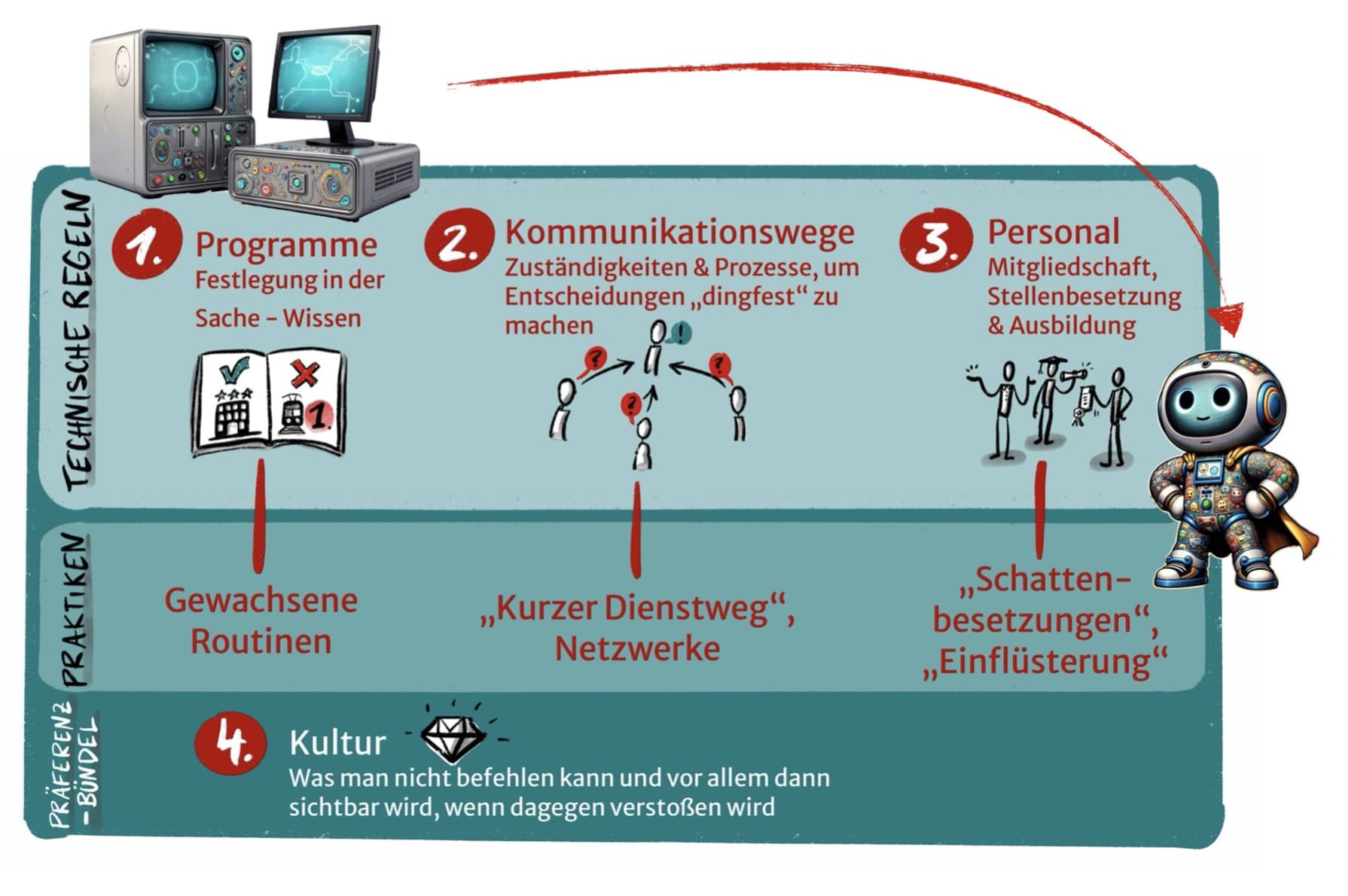

Jede beliebige Entscheidung in einer Organisation kann von einem KI-Assistenten getroffen und sogar begründet werden – das kann jeder durch eigenes Ausprobieren überprüfen! Der Wert (und auch das Problem) dieser neuen Art der Nutzung von Technik ist es, dass man durch die Antworten der KI-Assistenten überrascht werden kann, dass im Voraus nicht klar ist, wie sich der KI-Assistent entscheidet. Herkömmliche Programmierung, d.h. die Nutzung von Computerprogrammen, ist eine beliebig komplizierte Konditionalprogrammierung mit vielen „wenn – dann" Regeln, also kausale Festschreibung in der Sache. Z.B. sind alle Schritte bei der Online-Buchung eines Hotels genauestens festgelegt, so dass aus Organisationsperspektive alles zu diesem Geschäftsvorfall bereits vorentschieden ist. Herkömmliche Computerprogramme sind Ausprägung der Entscheidungsprämisse Programme.

Mit Hilfe von KI-Assistenten wird es nun möglich, auch die Entscheidungsprämisse Personal zu technisieren. Ein KI-Assistent kann als funktional äquivalent zu einer Person betrachtet werden, die auf eine Stelle mit einem Aufgabenprofil gesetzt wird. In beiden Fällen werden bestimmte Aufgaben und Entscheidungen übertragen inklusive der organisationalen Anweisung, dass Entscheidungen des Stelleninhabers zu befolgen sind. Die Entscheidungsprämisse Personal bedeutet nämlich, dass Entscheidungsspielräume, bedarfe und -macht delegiert werden an eine Blackbox, die undurchschaubar ist. Bei der Delegation von Entscheidungen vertraut man darauf, dass die Blackbox gute Entscheidungen treffen wird in dem Wissen, dass man vorher nicht weiß, wie die Blackbox sich genau entscheidet.

Menschen und KI-Assistenten qualifizieren beiden als Entscheidungsprämisse Personal, weil sie an Kommunikation teilnehmen, auf irgendeine, nicht direkt nachvollziehbare Weise zu Entscheidungen kommen und diese Entscheidung danach erklären können – wobei die Entscheidungsfindung und die Entscheidungsbegründung maximal lose gekoppelt sind. Manche KI-Kritiker werfen ein, dass generative KI nicht „wirklich versteht" (was auch immer das beim Menschen heißen soll), dass sie nicht angemessen Kontexte oder Argumente berücksichtigt (wobei: wer entscheidet, was angemessen ist?) oder schlechte bzw. falsche Entscheidungen trifft (und wieder: wer weiß, was richtig ist?). Das mag sogar alles sein, ändert aber nichts daran, dass prinzipiell menschliche Personen durch KI-Assistenten ersetzt werden können. Kategorial gibt es keinen Unterschied, lediglich bei der Frage, wer für welche Stelle geeignet ist, gibt es graduelle Unterschiede – für KI-Assistenten und auch für Personen. Folgt man dieser Argumentation, dann geht es nicht um die Frage, ob generative KI organisationale Entscheidungen treffen kann – sie kann! -, sondern wann, für was und wie sie in Entscheidungsprozessen eingesetzt wird. Das ist eine empirische Frage.

Die Praxis: Generative KI sickert in Organisationen ein und übernimmt Führungsaufgaben

Führung kann man verstehen als den fortlaufenden Prozess des Überprüfens, Entscheidens und Umsetzens (siehe Richter/Groth: Wirksam führen mit Systemtheorie). Empirisch kann man beobachten, dass es bereits Bereiche gibt, in denen KI-Assistenten bzw. KI-Systeme die Führungsschleife selbständig durchlaufen. Paradebeispiel ist die Kundenakquise: in regelmäßigen Abständen können KI-Bots das Internet oder andere Quellen auf potenzielle Leads durchforsten, eigenständig Emails formulieren und abschicken und auf darauffolgende Anfragen reagieren. Dieses Vorgehen muss man nicht mögen, mich selbst stören die zunehmenden Kaltakquiseversuche, aber es zeigt, dass eine komplexe Aufgabe, die Führung erfordert, an KI-Systeme ausgelagert werden kann.

In kleinerem Maßstab und punktuell werden in vielen Organisationen Tätigkeiten an KI-Assistenten delegiert, die auf Basis eines Briefings und der Bereitstellung eines Kontextes Unsicherheit bearbeiten und Entscheidungen treffen, die im Nachgang dann akzeptiert werden. Anstatt von Mitarbeitenden werden z.B. folgende Aufgaben von KI-Bots (z.T. besser) erledigt:

- Internet-Recherchen und Deep Research Anfragen (KI entscheidet, welche Quellen gelesen und wie aufbereitet werden)

- Monitoring von News-Quellen und Erstellung von zusammenfassenden Berichten

- Meeting-Protokolle

- Kategorisierung des Email-Postfaches

- Chatbots im Kundenservice, Verfassen von Kundenanschreiben

- Zugriffe auf Wissensdatenbanken der Organisation

- Strukturierung von unstrukturierten Daten

In all diesen Fällen gibt es Entscheidungsbedarfe (d.h.: das Endprodukt hätte immer auch anders aussehen können) und man verlässt sich (in Grenzen) auf das, was die KI-Assistenten liefern, d.h. überprüft nicht 100% von den Ergebnissen – genauso wie bei der Delegation an Personen. Selbst wenn Arbeitsergebnisse noch anpasst werden, gibt es also einen Teil der Arbeit und der darin enthaltenen Entscheidungsfindung, auf den man in keinster Weise mehr Zugriff hat, bei dem man sich also auf den KI-Assistenten verlässt. Empirisch beobachtbar trifft somit die KI Entscheidungen, mit denen in der Organisation weitergearbeitet wird.

Als Einwand kommt an dieser Stelle häufig der Hinweis, dass am Ende immer noch menschliche Personen entscheiden, welche Entscheidung der KI-Assistenten akzeptiert werden und welche nicht. Dies ist die Idee des „Human-in-the-loop", bei der den KI-Assistenten nur vorbereitende Tätigkeiten zugestanden werden, alle Ergebnisse also nur den Charakter einer Entscheidungsvorlage haben. Dieses Argument zielt aber lediglich auf die Zuschreibung von Verantwortung für Entscheidungen und nicht den Prozess, wie sich das Entscheiden vollzieht. In dem Maße, in dem KI-Entscheidungen regelmäßig gut sind bzw. besser werden, wird es zunehmend schwerer werden, den entscheidenden Anteil von KI an den Entscheidungen zu leugnen und die Rolle der menschlichen Personen als eine lediglich legitimatorische zu beschreiben.

Spätestens wenn in geeigneten Entscheidungssituationen die Vorschläge und Begründungen der KI-Assistenten wiederholt als (ausreichend) gut bewertet werden, menschliche Entscheider:innen also im Grunde nur noch abnicken, werden sich viele Organisationen die Frage stellen, warum man sich die menschlichen Entscheider:innen (für diese Entscheidungen) noch leisten sollte. Und wenn KI-Assistenen ausgewählte Entscheidungen mit Volumeneffekt so schnell entscheiden können, dass Menschen mit Prüfungen gar nicht hinterherkommen (man denke z.B. an die Bearbeitung von Anträgen mit diffuser Regelprüfung in Behörden oder Versicherungen), dann werden sich Organisationen diesen Effizienzgewinn nicht entgehen lassen. Auch wenn in Organisation menschlichen Personen Letztentscheidung und damit Verantwortlichkeit zugeschrieben wird, so ändert allein die Einbindung von KI-Assistenten die Entscheidungsprozesse und beeinflusst dadurch Entscheidungen. Die Einbindung von KI bleibt für Entscheidungen nicht folgenlos.

Als letztes sei noch darauf hingewiesen, dass es einen riesigen Bereich des Einsatzes von KI-Assistenten für Entscheidungen gibt, der fast gar nicht von Organisationen kontrolliert werden kann, nämlich die Nutzung von KI-Assistenten durch Mitarbeitende. Menschliches Personal soll für Organisationen (als Blackbox) Entscheidungen treffen und wird dafür auch verantwortlich gemacht. Im Innenverhältnis kann dieses Personal nun KI-Assistenten befragen, ohne es offenzulegen, und den Entscheidungen der KI-Assistenten (im Zweifel blind) folgen. Damit sind „Einflüsterungen durch KI-Assistenten" eine informale Praktik, wie KI-Assistenten die Entscheidungsfindung in Organisationen bereits heute weit verbreitet verdeckt beeinflussen.

Insgesamt gibt es also viele Wege, auf denen generative KI bereits heute in Entscheidungsprozesse von Organisationen einsickert.

Die Aufgabe von Führungskräften: Kontrolle von Intransparenz durch Kontextgestaltung

In immer mehr Bereichen können KI-Assistenten Situationen überprüfen, auf Basis der Prüfung Entscheidungen treffen und mit der Anbindung von passenden Werkzeugen auch umsetzen. Daher sollte man KI-Assistenten als Entscheidungsprämisse Personal ernst zu nehmen. Wie bei menschlichem Personal auch liegt die Herausforderung in der nicht auflösbaren Intransparenz von Blackboxes. Die entscheidende Frage lautet: In welchen Kontexten und für welche Aufgaben vertraut man KI-Assistenten? Ähnlich wie bei Personen dreht es sich also um Mitarbeiterführung – auch KI-Assistenten wollen geführt sein. Das Maß an Delegation wird zweifach eingeschränkt: zum einen durch den Grad an Vertrautheit gegenüber den genutzten KI-Assistenten, zum anderen durch die Rahmensetzung, innerhalb derer der KI-Assistent arbeiten soll. Um (besser) beurteilen zu können, welche Aufgaben man wie delegieren kann, gilt es, als Absprungbasis eine Vertrautheit zu entwickeln, sein „Personal" zu kennen. KI-Assistenten unterscheiden sich von menschlichem Personal, unterschiedliche Modelle reagieren sehr verschieden (Achtung: jedes Update des gleichen Sprachmodells kann dazu führen, dass sie sich nun anders verhalten, und sollte auf „Persönlichkeitsveränderungen" hin beobachtet werden) und sie reagieren sehr sensibel auf das Briefing (=Prompt) bei der Delegation. Es ist wichtig, sie in ihrer Andersartigkeit ernst zu nehmen, z.B. in ihrer Anfälligkeit, falsche Aussagen als überprüft darzustellen oder mit ihrer devoten Grundhaltung des Helfen-Wollens um jeden Preis zu rechnen – sonst erlebt man unerwünschte Überraschungen. Vor allem sollte man genau hinschauen, was sie (noch) nicht können. Die Sprachmodelle sind zwar mit den Daten des „ganzen Internets" trainiert, sie wissen also unfassbar viel, und sind genau deswegen recht hilflos, wenn es darum geht, eine Position zu beziehen. Sie verfolgen keine offensichtlichen (eigenen) Ziele außer eben allgemein stets hilfsbereit zu sein. Man kann sie als GPT – general purposes team member – verstehen, der allerdings keine eigene Geschichte hat, der sich durch Erfahrung nicht verändert und nach jedem Gespräch vergessen hat, worüber gesprochen wurde. KI-Assistenten halten sich recht sklavisch an ihr Briefing, d.h. man kann und sollte im Allgemeinen nicht damit rechnen, dass sie einen Führungsmove machen – also aus dem gebrieften Kontext heraustreten und reflektieren, ob sie etwas anderes machen sollten oder ob es angemessen wäre, den Kontext anzupassen.

Eben weil KI-Assistenten so generell einsetzbar sind und keine spezifische Intention außer Hilfsbereitschaft haben, besteht die wesentliche Aufgabe in der Führung von KI-Assistenten darin, die Kontexte zu definieren, innerhalb der sie arbeiten sollen. Je besser und genauer diese Rahmung gelingt, desto eher erfüllen sie Erwartungen. Zu einem guten Briefing gehört:

- Welche Aufgabe soll bearbeitet werden?

- Welche Daten sind relevant?

- Welche Perspektive soll eingenommen werden?

- Welche Grenzen gelten?

Diese Kontextgestaltung ist der zentrale Hebel, um die Intransparenz der KI-Blackbox zu kontrollieren – nicht durch Durchdringung, sondern durch bewusste Einbettung. Und bei KI-Assistenten wird noch deutlicher, dass man Arbeitsergebnisse von Blackboxes nur noch im Rahmen von Wahrscheinlichkeiten steuern kann. Anstatt deterministische Ergebnisse zu erwarten, muss man noch expliziter als bei menschlichem Personal auf probabilistische Erwartungen umstellen und dies in Entscheidungsprozesse angemessen integrieren, also: Welche Fehlerquoten sind tolerierbar, an welchen Stellen überprüft man stichprobenhaft, bei welchen Geschäftsvorfällen / Themen soll ein anderer KI-Assistent kontrollieren oder will man selbst informiert werden? Wir sehen: mit der Etablierung von KI-Assistenten verschiebt sich das Verhältnis von Vertrauen und Kontrolle beim Einsatz von Technik. Es wird neu darüber verhandelt, welcher Kontrolle man vertraut, wer die Kontrolle kontrolliert und wann Vertrauen kontrolliert werden sollte.

Anmerkung:

Wichtige Anregungen zu diesem Beitrag habe ich im Rahmen der Research Class des KIWIT-Projektes bekommen, vor allem zum Verhältnis von Technik und den unterschiedlichen Entscheidungsprämissen.